Nowe Statystyki Indeksowania w Google Search Console

Dotychczasowe statystyki indeksowania w Google Search Console były dość ubogie.

Mieliśmy trzy wykresy:

– ilość pobranych stron w ciągu dnia,

– ilość pobranych kilobajtów w ciągu dnia;,

– czas potrzebny na pobranie strony.

Każdy z wykresów miał jeszcze tabelę z trzeba wartościami: najwyższy, średni i najniższy.

Statystyki w tej formie nie zmieniały się przez wiele lat. Dane przedstawione w ten sposób nie był czytelne a i ich zawartość pozostawiała wiele do życzenia.

Na szczęście Google 24 listopada przedstawiło nową wersję Statystyk Indeksowania.

Nowe statystyki nietypowo odnajdziemy w o Ustawieniach GSC w sekcji Indeksowanie

Po wejściu od razu widać, że dostaliśmy do analizy więcej danych.

Wykresy statystyk

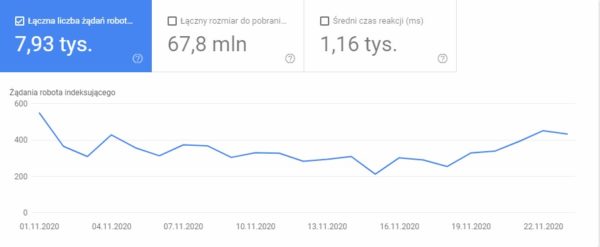

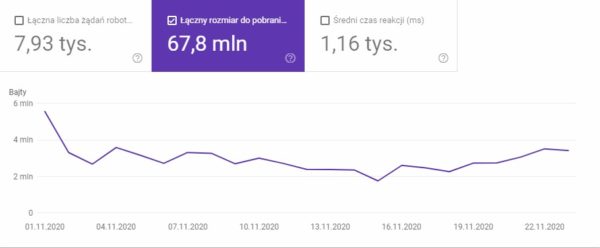

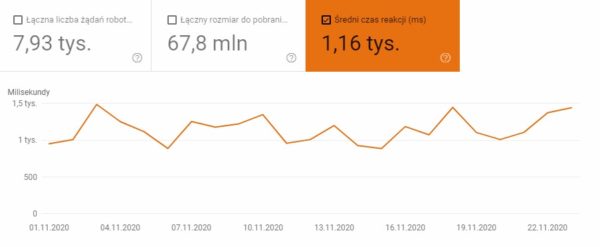

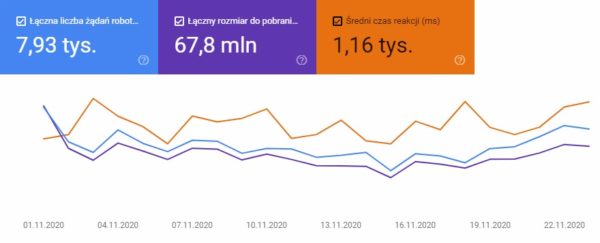

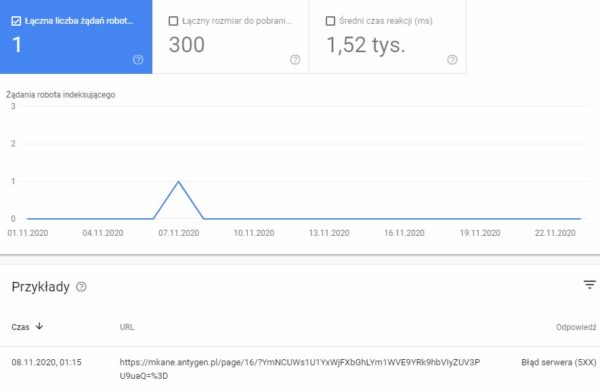

Pierwsze sekcja to wykres przedstawiający nam trzy wartości:

1. Żądania robota indeksującego:

2. Rozmiar pobranych plików i zasobów:

3. Średni czas reakcji

Standardowo wszystkie wykresy można wyświetlić w jednej chwili.

Informacja o ilości dni na razie jest myląca. W Ustawieniach jest 90 dni a na wykresach widać dane od 1.11.2020. Możliwe, że nowe statystyki od tego dnia są zliczane. I za jakiś czas będzie tutaj 90 dni.

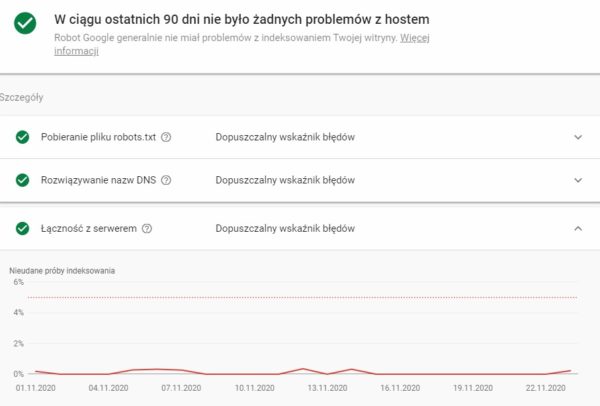

Stan hosta

W kolejnej sekcji znajdziemy informacje o problemach z serwerem / stroną lub ich braku.

Dla usługi dotyczącej jednej strony w tym widoku będą to dane skumulowane.

![]()

Kolory ikony oznaczają ilość problemów, zielony brak a czerwony to problemy.

Po zagłębieniu się ten raport otrzymujemy szczegółowe informacje. Trzy sekcje z wykresami.

W tym przypadku tylko kilka razy nastąpił problem łączności z serwerem. Ogólnie jest OK.

Gdy mamy usługę dla domeny i jest kilka stron to widzimy wszystkie strony w tym miejscu.

Wchodząc głębiej otrzymujemy wszystkie dane dla wybranego adresu.

Żądania indeksowania według stanu

Trzecią i na razie ostatnia sekcją z danymi to informacje pogrupowane według „stanu”.

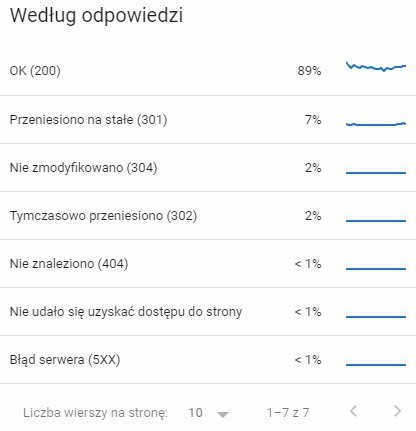

1. Według kodu odpowiedzi

Takie szczegółowe informacje można poddać juz analizie. Np kiedy wystąpiły błędy 500 i przy jakich adresach.

Taki widok szczegółów jest dostępny dla każdego wiersza w tych sekcjach.

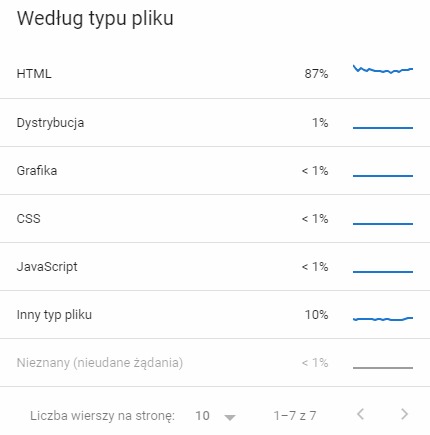

2. Według typu pliku

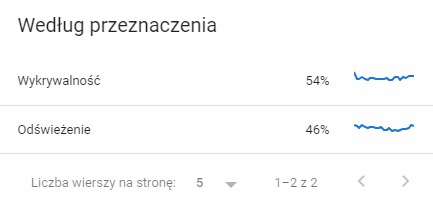

3. Według przeznaczenia

W tym przypadku chodzi o cel indeksowania:

Wykrycie: żądany adres URL nie został nigdy wcześniej zindeksowany przez Google.

Odświeżenie: ponowne zindeksowanie znanej strony.

Zaciekawiła mnie duża ilość adresów „wykrytych”, widzę tutaj duży bałagan do posprzątania:

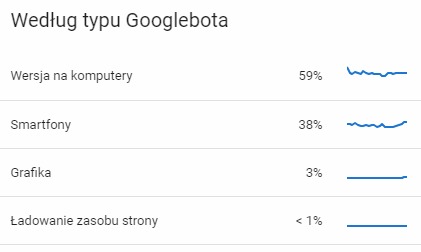

4. Według typu Googlebota

Ostatnia sekcja przestawania nam dane o tym, który GoogleBot pobiera naszą stronę.

Jak widzicie w przypadku strony bez wersji responsywnej ale z AMP głównym botem jest bot na komputery.

Sprawdziłem na innych stronach i jeśli jest RWD to głównym botem jest bot na smartfony.

Zawsze jednak występują obydwa typy botów.

Podsumowanie

Trzeba przyznać, że rozbudowanie statystyk to krok w dobrym kierunku.

Dostajemy więcej informacji, informacji które wreszcie można przeanalizować.

Możliwe, że rozbudowane statystyki będą najbardziej pomocne dla dużych stron.

Myślę jednak, że każda strona niezależnie od jej wielkości skorzysta na nowych poprawionych statystykach indeksowania i większej ilości przedstawianych w nich danych.

komentarzy

komentarzy

Większa ilość danych na pewno wpłynie na naszą korzyść przy podejmowaniu wielu decyzji.

Na pewno.

dlaczego Google nie zrobi całościowego narzędzia do audytu strony internetowej ?

Bo to nie leży w ich interesie. Jakby zrobili narzędzie, które sprawdza stronę w 100% to wszyscy by mieli to zrobione. Możliwe też, że trudno nawet im coś takiego zrobić.

Duży plus za screeny. Co prawda szukałem średniego czasu reakcji dla stron zlokalizowanych w Polsce, ale widzę, że u Ciebie jest na poziomie 1.1sec więc to też jest wartościowa informacja. Z tego co się zorientowałem to boty Google są zlokalizowane w US, więc ping do nich jest w przedziale 100-150ms. Tak więc w Polsce nie da się uzyskać mniejszego średniego czasu reakcji poniżej ~150ms. U mnie w statystykach Google czasy są na poziomie 250ms pomimo, że strony generują się w 5ms, a czas ładowania strony wg Chrome wynosi 29ms.

Czasy w dużej mierze zależne są od serwera. Poniżej 500ms jest już OK.