Blokada dostępu do plików CSS i JS w witrynie

Dwa dni temu Google przeprowadził akcję rozesłania informacji o problemie z dostępem do skryptów JavaScript i arkuszy styli CSS.

Dwa dni temu Google przeprowadził akcję rozesłania informacji o problemie z dostępem do skryptów JavaScript i arkuszy styli CSS.

W wiadomości o tytule „Googlebot nie może uzyskać dostępu do plików CSS i JS w witrynie ……”

można przeczytać taką informacje.

„Nasze systemy wykryły niedawno problem związany z Twoją stroną główną. Problem ten obniża jakość renderowania i indeksowania Twoich treści przez nasze algorytmy. Googlebot nie może uzyskać dostępu do plików JavaScript i/lub CSS z powodu ograniczeń zdefiniowanych w pliku robots.txt. Dzięki tym plikom możemy się dowiedzieć, czy Twoja witryna działa poprawnie, dlatego blokowanie dostępu do tych zasobów może doprowadzić do uzyskania przez witrynę gorszej pozycji w rankingu.”

Sprawdziłem wszystkie witryny, dla których dostałem taki monit i rzeczywiście. W każdym przypadku w robots.txt była blokada, która zabraniała botom Google wejść do katalogu w powyższymi plikami.

Nie jest istotne czy było to kilka katalogów czy jeden. Czy blokada dotyczy wielu plików czy tylko jednego, brak możliwości wejścia do tego miejsca został wskazany przez Google jako problem.

Wystarczy zablokować jeden plik z wielu by Google to zauważyło.

Warto także dodać, że często takie blokady są standardowe dla skryptów i zostały utworzone przez autorów a nie użytkowników.

W każdej chwili, nawet dla witryn, które nie otrzymały takiego monitu można sprawdzić czy Google ma dostęp do wszystkich adresów lub plików w witrynie.

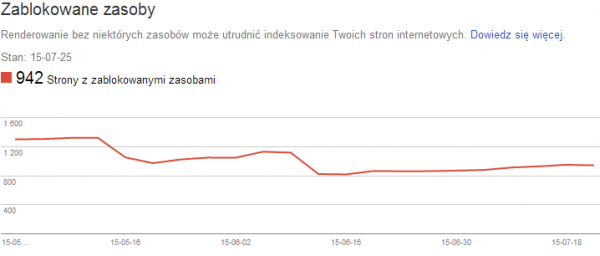

Taka informacja dostępna jest w Search Console (Google Webmaster Tools) w zakładce „zablokowane zasoby”

Google informuje nas o ilości adresów, na których są blokowane zasoby a na wykresie przedstawia zmiany w tych ilościach.

Informacja w tym miejscu może także dotyczyć innych plików niż JS i CSS. Bardzo wiele witryn, którymi się opiekuję blokuje dla Google swoje zasoby np wszelkiego typu panele.

W tym miejscu dostaniecie także informacje o tym, że jakaś inna witryna blokuje GoogleBota, jeśli np linkowaliście z niej grafikę.

Z tego co widzę częstym problemem są także różne widgety z inny witryn.

Z punktu widzenia SEO ciekawe jest także zdanie „Renderowanie bez niektórych zasobów może utrudnić indeksowanie Twoich stron internetowych” Z linkiem do pomocy dla tego panelu.

Informacja o tym, że blokada może spowodować problemy z indeksacją jest ciekawa. Choć ja na razie się z tym nie spotkałem, tzn z tym by rzeczywiście przez blokadę takich plików był problem z indeksacją.

Chyba, że blokuje się skrypty JS, które są istotne np generują menu albo linki to wtedy jeśli nie zostaną odczytanie dalsze strony nie zostaną zindeksowane. Wątpię jednak by w takim przypadku blokada nie była świadomym wyborem właściciela witryny.

Nie wiadomo jednak kiedy takie problemy, dla każdych zablokowanych JS, Google może stworzyć np tylko po to by zmusić nas do ich odblokowania.

Z drugiej strony przecież Google w każdej chwili może odczytać te pliki mimo blokady w robots.txt. Pamiętajmy o tym, że te zapisy są tylko instrukcją dla Google a to czy je zastosuje to już co innego.

Już teraz Google pomija przecież takie blokady w swoich testerach np PageSpeed Insights. W Search Console Google nie może renderować strony a w testerze wszystko jest OK. Dodatkowo w tym testerze wiele porad dotyczy właśnie CSS i JS co jednoznacznie wskazuje na to, że zostały przetworzone. Sprawdźcie u siebie np na witrynie, która dostała monit.

Także pytanie brzmi po co Google robi ten hałas..? Przyznam się, że nie wiem ale znając Google, zacznie wymuszać odblokowywanie tych miejsc tylko po to by zachować pozory tego, że sami tam nie wchodzą bo nie mogą.

Także warto co jakiś czas sprawdzać czy coś się w tej sprawie nie zmieniło i odpowiednio zareagować jeśli tak się stanie. A dziś już odblokować to co nie musi być zablokowane.

A może ktoś zauważył jednak problem z indeksacją po blokadzie tego typu plików? Z miła chęcią przeanalizuje takie przypadki.

komentarze

komentarze

W necie ludzie opisują przypadki, gdzie dostali powiadomienia a po sprawdzeniu okazało się, że wszystko jest OK. Jak dla mnie paranoja, bo bezpodstawnie straszą użytkowników. Jeśli już wysyłają, to powinni mieć 100% pewność, że problem jest na witrynie.

Tak, czytałem o takich przypadkach. U mnie jednak 100% się zgadza.

A mi się wydaję, że Google chce mieć dostęp co CSS’ów pod kątem sprawdzenia czy ktoś nie ukrywa sobie treści w divach, typu display:none itd.

Może i tak być.