Czasowe usunięcie witryny z Google

Trzy tygodnie temu na searchengineland.com pojawił się wpis, który dość mocno mnie zaintrygował.

Trzy tygodnie temu na searchengineland.com pojawił się wpis, który dość mocno mnie zaintrygował.

W skrócie – Grupon w USA na 6 godzin usunął się z wyszukiwarki Google.com. Dzięki temu dowiedzieli się, że około 60% ruchu klasyfikowanego w ich statystykach jako ruch bezpośredni ma powiązanie z Google.

W artykule znajdziecie wykresy, które obrazują automatyczny spadek ilości wejść bezpośrednich wraz ze spadkiem wejść z Google.

Z racji tego, że ten wpis nie ma być analizą tego co zostało tam napisane pozwolę sobie na 3 pytania:

– po co to zrobili? (duża amerykańska korporacja usuwa się sama z wyszukiwarki?),

– jaki udział w ruchu mają frazy związane z ich nazwą (frazy brandowe mają u nich na pewno bardzo duży udział, więc jak znikli z Google to ci co używali Google jako „ulubione” już nie weszli :)),

– jak się wyindeksować na 6 godzin z Google?

Po zapoznaniu się z wynikami „eksperymentu” najbardziej byłem bardzo ciekawy odpowiedzi na trzecie pytanie, nawet zadaliśmy takie pytanie w komentarzach ale nikt na nie nie odpowiedział.

Analizując temat widziałem tylko dwie możliwości:

– telefon do przyjaciela z Google i ładne poproszenie o pomoc,

– usunięcie się poprzez mechanizmy dostępne w GWT.

Jako, że telefony do USA kosztują nie mało a mój przyjaciel Google jest na urlopie :) postanowiłem przetestować opcje nr 2 czyli sprawdzić co mogę zrobić z GWT.

Don’t Try This At Home

Stwierdziłem, że test na jednej witrynie może nie być miarodajny, dlatego wybrałem cztery witryny:

– jednostronicowy serwis umieszczony na domenie – wiek 7 lat.

– dwie domeny, na których zrezygnowałem z witryn i przekierowałem je na inne domeny. Przekierowanie odbyło się na kilka dni przed testami także indeks był jeszcze prawie cały. Wiek obydwóch serwisów około roku.

– jeden serwis w subdomenie, istnieje przynajmniej od 4 lat.

Usuwanie

26 lipca 2014 roku dodałem wszystkie serwisy do GWT, ustawiłem w robots.txt blokadę dla botów wyszukiwarek i zleciłem usunięcie całych witryn.

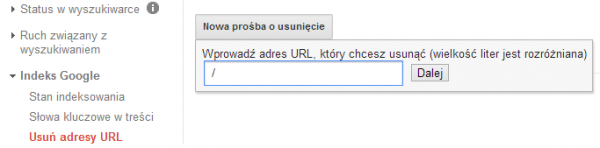

Zrobiłem to wpisując w oknie zgłaszania adresu znak „/”

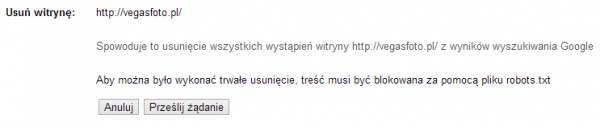

Jeszcze tylko potwierdzenie, że jestem świadom swoich działań i przesyłam żądanie

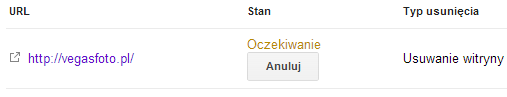

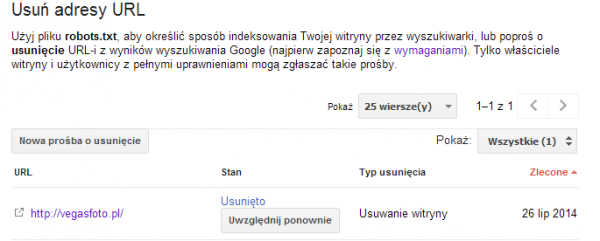

Na liście pojawia się moja prośba, którą w każdej chwili mogę jeszcze anulować.

Te same działania przeprowadziłem dla wszystkich czterech serwisów, wszystko trwało jakieś 10 minut a zakończyłem wysyłanie żądań około 20.07.

Kontrola

Od tej pory co godzinę, ręcznie kontrolowałem czy witryny już zostały usunięte. To kiedy witryna jest usuwana nie było dla mnie tak ważne, nie ustawiłem więc żadnego automatu a koło północy poszedłem spać.

Usuwałem witryny z indeksu już wiele razy i zawsze na drugi dzień już ich nie ma, ta informacja mi wystarcza.

Po wstaniu sprawdziłem w logach witryn, kiedy był na nich GoogleBot. Okazało się, że plik robots.txt, w każdej witrynie, został pobrany przez Google w ciągu 2 godzin od wysłania żadnaia usunięcia, w nocy nie był już pobierany ani razu.

Usunięcie

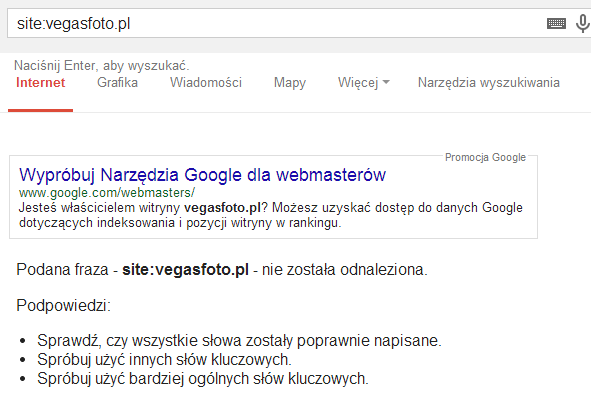

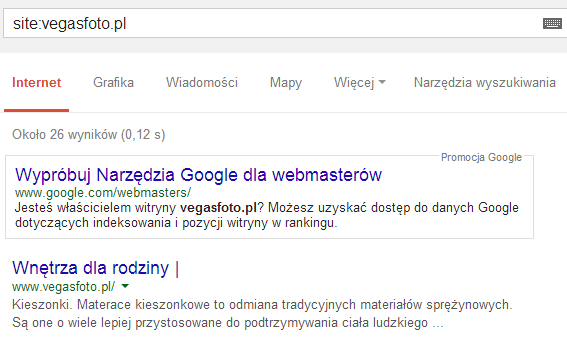

Po około 12 godzinach od zgłoszenia, sprawdziłem co się stało z serwisami. Wszystkie witryny zostały usunięte z Google.

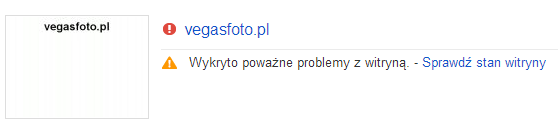

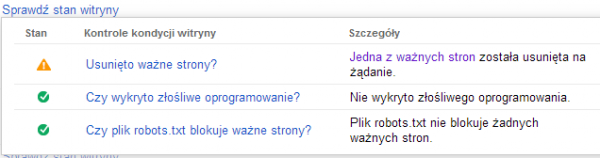

W GWT na liście witryn wyświetlała się informacja o poważnych problemach :)

z informacją o tym, że:

Teraz pozostaje więc tylko sprawdzić jak szybko Google przywróci je tak by były widoczne w SERPach.

Wracamy do indeksu

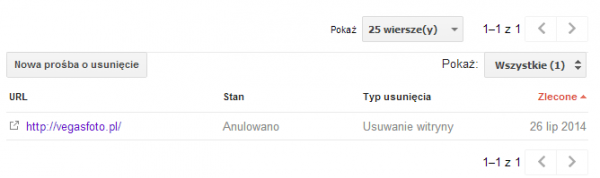

27 lipca około godziny 10.00 zakończyłem klikanie w GWT w button „Uwzględnij ponownie”

anulując w ten sposób moje żądanie

W miedzy czasie na 3 witrynach usunąłem z robots.txt blokadę dla robotów, na jednej z witryn świadomie ją pozostawiłem.

Postanowiłem także ręcznie sprawdzać czas powrotu, ustawiłem jednak automat, który mógł to sprawdzać, jakbym musiał zająć się czymś innym.

Okazało się jednak, że nie musiałem czekać długo. O 11.53, czyli po niecałych 2 godzinach, wszystkie witryny były już widoczne w Google.

Co ciekawe, ponownie sprawdziłem w logach witryn kiedy GoogleBot sprawdził robots.txt i okazało się, że powrót do indeksu nie ma nic wspólnego z blokadą w robots.txt. Google pobrał te pliki dopiero wieczorem, czyli już po przywróceniu ich do wyników.

Stan indeksacji

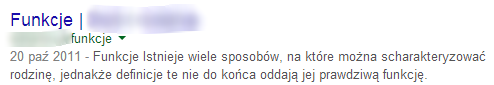

W trakcie usuwania witryn zapisałem sobie stan ich indeksu by porównać go po powrocie:

– witryna jednostronicowa – tutaj nic się nie zmieniło,

– jedna z przekierowanych witryn – przed 46 podstron, po powrocie 26,

– druga z przekierowanych witryn – przed 31 podstron, po powrocie 31,

– subdomena – przed 17 podstron, po powrocie także 17.

Niestety mam za mało danych by rzetelnie ocenić sytuacje, ilość zainteresowanych podstron spadła tylko dla witryn, które przed testem był przekierowane przez kilka dni.

Możliwe, że Google czyścił ich podstrony dlatego ich ilość się zmieniła i nie ma to żadnego powiązania z moim testem.

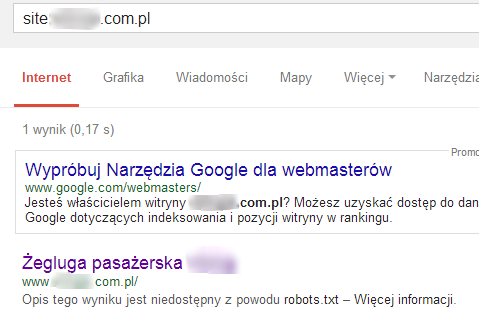

Co ciekawe, witryna, na której pozostawiłem blokadę dla botów została także przywrócona, w takim samym czasie. Jednak w opisie widniała informacja o tym, że jest blokada w robots.txt oraz tytuł, który nie był aktualnym tytułem witryny.

Był to tytuł witryny, która była umieszczona na tej domenie zanim ją kupiłem.

Możliwe, że jest to efekt wyciągnięcia fraz z linków.

Jako jeszcze jedną ciekawostkę dodam, że na jednej z witryn, po jej powrocie była data utworzenia kopii z 2011 roku. Nie było by nic dziwnego w tym, jakby nie to, że mam tą domenę od 2013 roku.

Data była zła ale treść OK.

Podsumowanie

Jak się przekonałem istnieje bezproblemowa możliwość czasowego usunięcia witryny z indeksu bez znajomości w Google. Oczywiście nie mogę być pewien tego, że witryny zawsze wracają po 2 godzinach, i że zawsze jest tak bezproblemowo.

Zakładam jednak, że witryny usunięte poprzez żądanie w GWT, po jego anulowaniu wracają do indeksu.

Do indeksu wracają także witryny, w których usuniemy z robots.txt blokadę dla Google, bez anulowania w GWT, dzieje się tak jednak po kilku miesiącach (180dni), takich przypadków miałem już parę.

Jak widać usunięcie z ten sposób nie jest ostateczne a wręcz można napisać, że jest to usunięcie czasowe a od nas i Google zależy jak długo będzie trwało.

Postanowiłem sprawdzić czy szybkość przywrócenia będzie taka sama po dłuższym usunięciu, dlatego kontynuuję test poprzez ponowne usunięcie dwóch testowych witryn. Postaram się je przywrócić do indeksu pod koniec sierpnia.

Pozostaje jeszcze sprawdzić tezę Grupona o 60% udziale wyszukiwarek w wejściach bezpośrednich ale by to zrobić trzeba usunąć witrynę o odpowiednim ruchu z organica.

Może ktoś chętny? :)

komentarzy

komentarzy

Ciekawe i fajnie, że się tym podzieliłeś tylko zastanawiam się nad sensem robienia takich rzeczy? czy np. da się w ten sposób szybko pozbyć miliona zbędnych podstron zanim G samo je przecrawluje? (co trwa wieki nawet jak się go pogania)

W takim przypadku lepiej zablokować dostęp do tych podstron. Da się usunąć bez problemów wiele niepotrzebnych lub powielonych podstron.

Używam usuwania bardzo często, tym bardziej jak skrypt robi dziwne rzeczy, których nie można przewidzieć.

Według mnie samo usunięcie w GWT i blokada w robotach nie ustala, żeby serwis nie był indeksowany. Żeby urle nie były indeksowane, to robot musi zobaczyć noindex, a jak jest robots.txt to on tam nie wejdzie i nie zarejestruje tego. Skończy się tak, że będzie tak jak pisałeś, gdzie w serpach widziałeś swoją strone z komunikatem o robotach.

Już próbowałem usuwać same urle przy pomocy GWT i część linków wracała po pewnym czasie, bez jakiejkolwiek ingerencji. Więc podejrzewam, że to dlatego mogły tak szybko wrócić te urle do indeksu.

Może jako trzeci test wykonać taki z usunięciem w GWT i ustawieniem noindex na jakiś czas. Potem zdjęcie noindex i sprawdzenie czy strona wróci po takim samym czasie do serpów.

Jeśli Google będzie znało URL to rzeczywiście może wrócić bo taka „prośba” jest ważna przez jakiś czas. Gdzieś pisało, że 180 dni. Jak zostawi się blokadę to teoretycznie bot nie wejdzie, choć spotkałem się z sytuacją, że wszedł i jeszcze informował o różnych problemach na tych podstronach z blokadą.

Łatwy sposób na usunięcie podstron w indeksu to podanie botowi nagłówka 404 lub lepiej – 410.

Jeśli do usuniętych urli nieprowadzą żadne linki to najczęściej nie wracają, jednak dla pewności można dodać noindex w meta.

Dodam, że takie urle z blokadą powinny po jakimś czasie znikać ale może to trochę potrwać.

Prośba w GWT wygasa już po 90 dniach (nie 180), a sam mechanizm działa bardzo szybko – zazwyczaj ok. 2-3 godzin w obie strony.

Kontrolowałeś pozycje przed i po teście? ;)

Nie, nie interesował mnie ten aspekt. Podejrzewam jednak, że nie powinno się nic zmienić, czy może jest inaczej?

„jak się wyindeksować na 6 godzin z Google?” – ustawić skrypt, który jak widzi, że ktoś przechodzi z Google.com to przekierowuje na b lankpage? Proste i mozna ustawić dokładnie na taki czas, jaki się potrzebuje.

rozwiń tą myśl bo nie rozumiem.

Ciekawi mnie jak ten test wpłynął na pozycje tych stron w wynikach wyszukiwania. Masz może takie dane?

Nie było wpływu, pozycje były takie jak przed usunięciem. Jednak trzeba pamiętac, że trwało to tylko kilka godzin. Po dłuższym czasie pozycje na pewno by się zmieniły.

Duży site miały Twoje strony?

Pisałem o tym we wpisie w punkcie „Stan indeksacji”

Twoja strona została usunięta z SERP, ale w indeksie siedziała nadal – o tym świadczy fakt, że tak szybko wróciła. Czy ja coś pomyliłem ? W dodatku trzeba by poczekać dłużej i wtedy sprawdzić czas powrotu witryny do indeksu. Test bardzo ciekawy!

Można tak to nazwać, że została usunięta z wyników ale w bazach była. Potocznie używa się indeks jako wyniki bo nie wiemy co oni sobie zostawiają. Co do dłuższego usunięcia, niedługo to opisze.

[…] końcowe efekty testu, dotyczącego usuwania witryn z wyników wyszukiwania. W poprzednim wpisie „Czasowe usunięcie witryny z Google” opisałem proces usuwania i przywracania po około jednym dniu. Po tym wpisie postanowiłem […]