W ciągu ostatnich tygodni parę osób pytało się mnie co się stało, że mój blog wypadł z top20 na pozycjonowanie i pozycjonowanie stron.

Zastanawiałem się chwilkę czy publicznie się tutaj obnażyć :) i pokazać, że też popełniam błędy. Tylko chwilkę bo doszedłem do wniosku, że warto to napisać by pokazać, że w naszej pracy trzeba pamiętać o wszystkich co się robi.

Zacznę przekornie trochę od końca :)

Pewnego pięknego dnia postanowiłem przyjrzeć się dlaczego zegar systemowy na pewnym moim serwerze, nie wskazuje poprawnej godziny.

Na każdym z moich serwerów synchronizuję czas z jakimś serwerem czasu, dlatego byłem tym faktem mocno zdziwiony. Przejrzałem skrypcik, który za to odpowiada i znalazłem trywialny błąd w ścieżce. Poprawiłem to i zapomniałem o sprawie.

Następnego dnia mój serwer przestał dawać jakiekolwiek oznaki życia. Telefon do serwerowni – hard reboot – serwer wstał. Oczywiście spędziłem trochę czasu na analizę logów, nic nie znalazłem. Pozostaje czekać a w duchu nadzieja, że to tylko ten jeden raz.

Nadzieja mnie nie opuszczała aż dwa dni :), oczywiście do czasu gdy serwer znowu padł. Znowu musiałem poprosić o pomoc „Pana z serwerowni”, znowu szukanie w logach i nic…

Nie czekałem wiele, w kolejnym dniu pojechałem i wymieniłem dysk, przeniosłem dane i odpaliłem serwer. Oczywiście z nadzieją na koniec problemów a jeśli nie to czeka mnie wymiana pamięci.

Nawet mi to pasowało bo chciałem zwiększyć tam ilość ramu z 4 do 8Gb.

Czekam więc, zadowolony, że mi szybko poszło. Wymiana dysku z przeniesieniem danych to tylko 20 minutowa przerwa w dostępności dla ludzi i botów.

Niestety następnego dnia serwer padł, miałem już wybrane pamięci, jednak podczas ponownego przeszukiwania logów znalazłem coś ciekawego.

Zawieszanie się serwera następowało kilka godzin po komunikacie o braku synchronizacji procesora z czasem systemowym. Trochę poszukałem w necie i okazało się, że taki efekt, daje przełączenie sposobu obliczania godziny z biosu na jedną z usług (hwclock –systohc).

Podczas czytania o tym okazało się, że w niektórych konfiguracjach sprzętu, w takiej sytuacji następuje kuriozalna próba obniżenia taktowania procesora tak by się zsynchronizował z czasem systemowym.

Najprościej pisząc, procesor chodził coraz wolniej by się dostosować do czasu systemowego. Nie wiem czy finalnie procesor tak zwalniał że nie dawał rady przeliczać, czy też po prostu się zawieszał. Efekt był taki, że maszyna nie odpowiadała nawet na ping.

Wstrzymałem więc uruchamianie skryptu do synchronizacji, postanowiłem poczekać z zakupem pamięci i znowu z nadzieją czekam co będzie dalej.

Tydzień później okazało sę, że był to strzał w 10. Pracy mam wiele, więc rozwiązane = zapomniane.

(trochę długi mi wyszedł ten „koniec” :) )

Z pewnością, że to koniec problemów zbiegły się nagłe spadki pozycji mojego bloga o 10-20 miejsc. Odebrałem to jako czkawkę i niewiele się tym przejąłem.

Kilka dni później wszedłem na LinkMe i gdzie okazało się, że makabrycznie spadła mi ilość punktów, dodatkowo jedna ze stron mojego zaplecza posiada „brak autoryzacji” i nie można jej ponownie autoryzować.

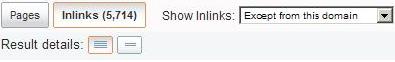

Punkty spadły mi na tyle by dla każdej linkowanej nim strony rozpoczął się proces automatycznego ściągania linków. Najbardziej oberwały dawno dodane strony, w tym ten blog. Liczba linków spadła o jakieś 40%. Już wiedziałem dlaczego pozycjonowanie bloga nie powoduje utrzymania lub wzrostu pozycji tylko ich spadek.

Gwoli wyjaśnienia do tego bloga prowadzi bardzo mało linków, jest to ciągle swoistego rodzaju mój test i utrata nawet 50-100 linków, które mają minimum 2 lata jest bolesna.

Sprawę punktów rozwiązałem, zakasałem rękawy by pozycje wróciły i ponownie o sprawie zapomniałem.

Jednak to jeszcze nie koniec tej historii…

Pod koniec lipca mój blog poleciał w otchłań poza top100. Zdziwiłem się mocno bo aż tyle linków nie straciłem by zasłużyć na taki los. Niewiele mogłem jednak zrobić oprócz kontynuowania mojej strategi.

Na początku sierpnia rutynowo zalogowałem się na moje konto w Link-Vault, do którego loguje się średnio raz na kwartał.

Od razu wyjaśniła się sprawa mojego spadku.

W tym systemie mam dodaną tylko jedną witrynę z zaplecza ponieważ i tak nigdy nie udało mi se wysycić wszystkich punktów jakie otrzymałem. Konto w tym systemie mam gdzieś od 4 lat.

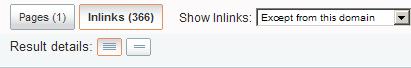

Tą jedną, jedyną moja witrynę spotkał taki sam los jak jej „koleżankę” w LinkMe. System odrzucił ją jakoby nie wyświetlane były na niej linki.

Efektem braku strony dającej punkty było to, że przy każdej linkowanej w tym systemie witrynie, zamiast linków, widniała liczba 0.

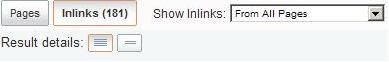

Linki do tego bloga w tym systemie budowały się powoli przez ostatnie 3,5 roku. Nie było ich dużo, około 700 szt.

Jak widać jednak były dość ważne. Podejrzewam, że miałem tu linki z zaplecza pozycjonowanego na „pozycjonowanie”. Ktoś ładnie wspierał moje testy.

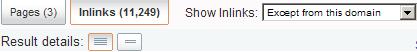

Ciekawostką jest to, że po ponownej autoryzacji tej samej witryny dostałem za nią dwa razy więcej punktów niż przedtem.

Podsumowując przez jakieś dwa tygodnie straciłem do bloga kilkaset linków bo, jak widać, nie traktuje poważnie systemów.

Nie przez to, że miałem problemy z serwerem, czego efektem było utracenie punktów. Tylko przez to, że nie pomyślałem po problemach by wszystko sprawdzić. Zająłem się po prostu czymś innym.

Dodam też, że adresy e-mail jakie podaje do kontaktu prawie nigdy nie odbieram.

Do LV loguje się sporadycznie bo nie mam po co, do tej pory ten system był najodporniejszy na wszelkie problemy z serwerem. Polskie systemy przysyłały monity a LV cierpliwie czekał.

Przez ostatnie parę dni obserwuję, że pozycje bloga rosną, jednego dnia „pozycjonowanie stron” – 100 pozycja, innego „pozycjonowanie” – 70. Tydzień temu obydwie frazy były w okolicy top200, jest więc tendencja wzrostowa co mnie cieszy.

Odbudowa struktury linków trochę potrwa ale jako pozycjoner nie przejmuję się tym – cierpliwości u mnie nie brak. Poczekamy to wrócimy :)

Jest i pozytywna strona mojego niedopatrzenia bo przestały do mnie przychodzić seryjne zapytania o pozycjonowanie :)

![]()

komentarze

komentarze