Googlebot i protokół HTTP/2

Jak wiemy Googlebot to określenie botów pobierających strony internetowe przez Google. Strony te później przez odpowiednie algorytmy są oceniane.

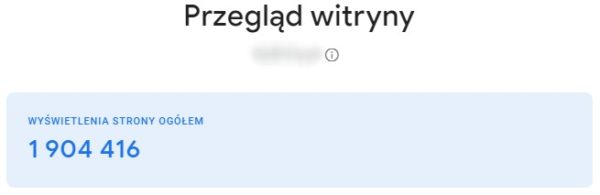

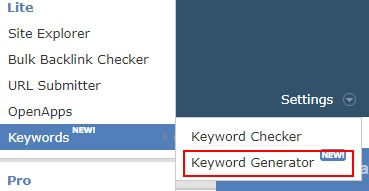

Dzięki tymi działaniom budowane są listy na słowa i frazy.

O samym Googlebot pisałem już wiele razy.

Tym razem jest okazja bo Google ogłosiło, że od połowy listopada Googlebot będzie pobierał strony przy użyciu HTTP/2.

I przyznam się, że choć tyle lat jestem już w SEO to Google jeszcze potrafi mnie zadziwić :) Zadziwić bo myślałem, że dawno już to robią.

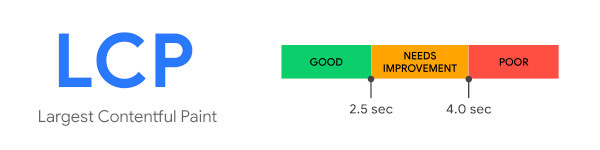

Od długiego już czasu wiele ich działań wymuszało optymalizację szybkości strony a teraz się okazuje, że sami nie wykorzystują nowych i lepszych technologii.

Co to jest HTTP/2

Protokół HTTP (Hypertext Transfer Protocol) jest odpowiedzialny za przysyłanie danych w sieci WWW.

Obecnie w większości serwery wykorzystują wersje HTTP/1.1, która pochodzi z 1997 roku.

Wersja HTTP/2 zostało opublikowana w 2015 roku (ma Google tempo :/) a w 2018 pojawiła się wersja HTTP/3. … Czytaj dalej »

Komentarz(1)

Komentarz(1)