9 urodziny Google

Tak, tak to dziś, nie wiem co im życzyć.. chyba tego by nie namieszali tak w algorytmie, że stracę źródło dochodu :)

i oczywiście nieograniczonych zasobów w Data Center…

Tak, tak to dziś, nie wiem co im życzyć.. chyba tego by nie namieszali tak w algorytmie, że stracę źródło dochodu :)

i oczywiście nieograniczonych zasobów w Data Center…

Ot, taka ciekawostka…

Do napisania tego wpisu zmusił mnie niejako jeden z właścicieli systemów wymiany linków, twierdząc, że się „czepiam” :/

Postanowiłem dokładnie sprawdzić na ilu stronach, na których niby wyświetlają się moje „pozycjonujące” linki, w systemach wymiany linków stałych, to „puste” miejsca zabierające tylko punkty.Jak ważne jest to aby system skutecznie wyłapywał wszelkie oszustwa nie trzeba nikomu chyba tłumaczyć.

Sprawdziłem trzy systemy, w których posiadam aktywne konta, są to dwa polskie systemy LiveLink, LinkMe oraz najpopularniejszy na świecie system linków stałych – Link Vault.

W tym miejscu zaznaczę, że nie jestem zwolennikiem pozycjonowania stron tylko poprzez systemy. Moim zdaniem powinny być one pomocne tylko jako dodatek do tego, co robimy. Jak wiemy różnie to bywa, są tacy „pozycjonerzy”, dla których jest to jedyny sposób pozyskania linków i do nich głównie kierowany jest ten tekst, choć nie tylko.

Sprawdzanie odbywało się w dwóch etapach.

Pierwszy, sprawdzenie skryptem, specjalnie napisanym do tego celu. Skrypt wyszukuje w kodzie strony danego adresu strony, czyli linku, który powinien tam być, nie anchora bo to mogłoby zaciemnić wynik.

Skrypt zgłaszał się jako „Mozilla/4.0 (compatible; MSIE 5.0; Windows NT) z timeout ustawiony na 30 sekund.

Drugi etap to sprawdzenie ręczne, stron oznaczonych jako „brak linku”.

Dla stron, które się nie otwierały lub dawały 404, 500 lub błędy skryptów tam umieszczonych, sprawdzałem kopie Google, jeśli nie znalazłem kopii podstrony zakładałem, że link tam jest.

Niestety, po zliczeniu wszystkiego zauważyłem, że popełniłem mały błąd bo nie zapisałem sobie ilości stron, na których nie byłem w stanie ustalić „jest/nie ma” jednak takich przypadków nie było wiele, bodajże po 3-5 dla polskich systemów i 1 dla LV.

LiveLink

Sprawdziłem 264 strony, nie znalazłem linku na 55 szt. co daje 20,83% – nie mało nieprawdaż?

W przypadku tego systemu najczęściej po prostu nie było linków, widziałem parę stron z przekierowaniem 301 z podstrony, którą miałem na liście, na stronę główną. Kilka podstron nie istniało, mimo, że strona działała a jej struktura nie została zmieniona, najczęściej były to katalogi, gdzie wpis został usunięty, więc podstrona znikła.

Jednak, co ciekawe, znalazłem jeden kwiatek, czyli zaparkowaną domenę, z kopią wskazującą, że ten stan trwa już od tygodnia.

Myślę, że spider tego systemu powianiem to dawno już wyłapać.

Nie ukrywam, że w przypadku tego systemu pierwszą akcję sprawdzania przeprowadziłem prawie dwa miesiące temu, niestety mimo zgłoszenia przez „detektywa” strony nie zostały usunięte i dość duża ilość ponownie została wyłapana jako nie emitujące linków.

LinkMe

Sprawdziłem 210 strony, nie znalazłem linku na 28 szt. co daje 13,33%. Jeśli chodzi o % już jest lepsza sytuacja, spider systemu jest trochę bardziej skuteczny niż w LiveLink.

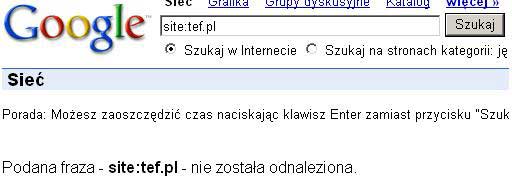

Tutaj tak samo najczęściej po prostu nie było „mojego” linka, były nieistniejące podstrony oraz 301. Nie obyło się też bez „kwiatka”, jakim okazał się zbanowana domena w Google.

Pozycjonowanie stron dzięki zbanowanym domenom … hmm.

Niestety nie jestem w stanie określić, kiedy to było, więc istnieje szansa, że np dzień prędzej i bot tego systemu nie zdążył jej wyrzucić.

Link Vault

Sprawdziłem 226 strony, nie znalazłem linku na 12 szt. co daje 5,31%.

Jak widać w tym systemie najmniej traci się punktów na „puste linki”, więc pozycjonowanie tym systemem będzie bardziej skuteczne.

Faktem jest, że myślałem, że w tym systemie będzie mniej takich stron.

Nie znalazłem tutaj żadnego ciekawego przypadku a linków po prostu nie było.

Podczas sprawdzania tych systemów, założyłem, że górna granica tolerancji, brakujących linków, to 3-5%. Założyłem też, że nie jestem odosobnionym przypadkiem, dlatego uważam, że patrząc na system jako całość, procenty, niewiele się zmienią.

Niestety żaden z systemów się w tej granicy nie zmieścił.

LV był blisko, jak widać, system jest od strony kontroli najlepiej dopracowany.

Procenty polskich systemów są niestety za wysokie, Panowie Właściciele -Administratorzy!

Już 13,33% jest przerażające, ale 20,83% to już koszmar.

Na każde 1000 linków 133szt. albo 208szt. po prostu nie istnieje. Najgorsze jest to, że te ilości, często, pozwoliłyby na pozycjonowanie kolejnej frazy albo wzmocnienie zaplecza.

Jeden, jednak plus dla systemu LiveLink, jest to eksport linków do pdf. Naprawdę ułatwia to automatyczne sprawdzenie, za to w LinkMe, mam wrażenie, że podzielenie listy po 10szt. na podstronę jest celowym działaniem by utrudnić sprawdzanie. Kopiowanie tych linków zajęło mi kilkanaście minut, jakbym chciał sprawdzić 2000 to pewnie zniechęciłbym się szybko. Może zrobiłbym to raz ale nie cyklicznie.

Niestety LV nie jest lepszy od LinkMe pod tym względem, fakt listę utworzyłem szybciej, ale tylko dzięki rozszerzeniu FireFoxa „Web Deweloper” + czyszczenie z niepotrzebnych rzeczy.

Na koniec chciałbym dodać, że nie oceniam skuteczności tych systemów, pod kątem pozycjonowania. Faktem jest jednak to, że jakby ilości stron, które nie emitują linki, były mniejsze to systemy te byłby jeszcze bardziej skuteczne.

Zachęcam wszystkich do samodzielnego sprawdzenia swoich list, oraz zgłaszania tego do systemów, na pewno przyczyni się to do wzrostu wartości Waszych punktów.

P.S.

W LinkMe dziś „zadenuncjuję” te strony jednak Pana z LiveLink, jeśli jest zainteresowany proszę o kontakt, bo kolejny raz na zgłaszanie tracić czasu nie będę.

Od dnia dzisiejszego Google nie oznacza już stron w wynikach uzupełniających.

Tak piszą na Google Webmaster Central Blog

„……Given all the progress that we’ve been able to make so far, and thinking ahead to future improvements, we’ve decided to stop labeling these URLs as „Supplemental Results.”

Zobaczymy, czy dzisiejsze zmiany, bo pewnie nie chodzi tylko o słowa „wynik uzupełniający” wpłyną na odwiedzalność naszych stron czy ich pozycjonowanie i jakie to zmiany będą, na plus czy minus.

Tak się zastanawiam ile dzisiaj punktów przybyło pozycjonerom w systemach wymiany linków, które nie zliczały stron w SI.

Jak zawsze, przy większych zmianach w Google, na wszelkiego typu komentarze i przemyślenia radzę poczekać kilka tygodni.

Zajmując się pozycjonowaniem lub posiadając kilka własnych stron, prędzej czy później, natkniesz się na swoje podstrony w „wynikach uzupełniających” (ang. supplemental result).

Temat SI (ang. supplemental index) był szeroko komentowany i omawiany w 2006r. na wielu forach i blogach można było znaleźć opinie i porady dotyczące nowego wtedy mechanizmu, niektóre opinie ważne są do dziś jednak wiele rad nie jest tak skutecznych jak się wydawało wtedy.

Google tłumaczy, że „Wynik uzupełniający to wynik wyszukiwania pobierany z naszego indeksu pomocniczego. Wobec witryn trafiających do indeksu pomocniczego możemy zastosować mniej ograniczeń niż wobec witryn uwzględnianych w indeksie głównym. Na przykład liczba parametrów w adresie URL może spowodować wykluczenie witryny z aktualizacji indeksu głównego, jednak roboty mogą ją uwzględnić w indeksie witryn uzupełniających.”

Czy aby na pewno ta oficjalna wypowiedź jest bliska prawdy? Czy strony w indeksie pomocniczym na pewno mają mniej ograniczeń ? Myślę, że łatwo zauważyć, że strony/podstrony w SI są traktowane po „macoszemu” i niewiele ma to wspólnego z „ograniczaniem ograniczeń”.

Co trafia do SI? – przyczyny:

– nie istniejące podstrony – 404 czasowe lub stałe,

– przekierowanie 302 – podstrony nie są wyindeksowane jednak „czasowo” nie istnieją,

– przekierowanie 301 – wyindeksowanie takich podstron trwa często kilka miesięcy,

– podstrony z errorami,

– podstrony z powieloną treścią w obrębie danej domeny – np. w blogach bardzo często powieloną treścią są podstrony z komentarzami, archiwum według daty,

– powielona treść z innej strony,

– podstrony opuszczone (ang. Orphaned pages) – czyli podstrony, do których z różnych przyczyn nie prowadzą żadne linki,

– wcześniejsze wersje – przy zmianie treści obydwie wersje są zaindeksowane,

– zmiana adresów url – te stare mogą być widoczne jeszcze kilka miesięcy,

– długie adresy, dużo zmiennych – np. sesja w adresie,

– brak zróżnicowanych meta Tagów wewnątrz serwisu – często kilka tysięcy podstron ma ten sam title, description i keywords,

– małe różnice w treści pomiędzy podstronami – np. w katalogu produktów, różnica często to tylko kilka linijek opisu lub sama nazwa + numer,

– podstrony bez treści – np. tylko menu,

– zła nawigacja – podstrony umieszczone bardzo „głęboko”,

– posiadanie w obrębie witryny podstron o małej zawartości treści w innym języku niż inne podstrony. O tym za chwilę…

Na koniec najważniejsza przyczyna, czyli mała ilość linków lub bardzo słabe linki do danej domeny.

Do wykonania serii testów i zajęcia się analizą SI zmusił mnie fakt trafienia do wyników uzupełniających podstrony mojego klienta, która posiadała oryginalną treść. Było to około 10 wersów tekstu w języku rosyjskim.

Byłem bardzo tym zdziwiony, ponieważ do domeny prowadziło kilkadziesiąt tysięcy linków, była ona zaindeksowana w 100%, ruch, jaki generowała pozwalał przypuszczać, że plasowała się w czołówce stron o tej tematyce.

Na potrzeby mojej analizy wykonałem na przestrzeni 6 miesięcy kilkadziesiąt różnego rodzaju testów. Wszystkie domeny, jakimi się opiekuję były bacznie w tym czasie obserwowane. Pozwolę sobie opisać tylko kilka z testów.

1. Katalog stron – domena zaindeksowana w 80%. Około 30 tys. linków stałych. Strona ta długo opierała się Google by nie zakwalifikowało jej do SI. Jednak mimo, tej mocy skrypt (Easy-Directory) jak się okazało spowodował stan, w pewnym momencie było około 80% podstron w wynikach uzupełniających.

Pierwszą czynnością ratunkową było dołożenie na wszystkich podstronach daty i godziny wraz z jedną linijką tekstu oraz usunięcie meta Tagów z części podstron.

Już ten mały zabieg spowodował widoczny spadek obecności tej domeny w SI. Po około 3 miesiącach nastąpiła zmiana układu podstron zwanych jako „szczegóły wpisu”, dołożone zostało h1 oraz h3, zmienione zostały urle tak by nie powielały się wśród stron postawionych na tym skrypcie oraz wstawione zostały automatycznie pobierane RSS z innej strony.

Do 3 kategorii zostały umieszczone linki bezpośrednie z 6 domen.

I to można powiedzieć był „strzał w 10”, SI zostało ograniczone – ruch wzrósł o ponad 100%.

2. Katalog na skrypcie QlWeb – tutaj sytuacja można powiedzieć była „tragiczna” cała domena wraz ze stroną główną trafiła do „suplementala”. Wszystkie nowe wpisy automatycznie i grzecznie wędrowały za resztą w otchłań niebytu.

W tym przypadku nie pomogły żadne zmiany treści + dołożenie elementów różnicujących podstrony. Dopiero kilkanaście linków z mocnych domen wyprowadziło część podstron z indeksu pomocniczego.

3. Forum internetowe – jak wiemy tutaj jest treść oryginalna, więc dlaczego SI?

Jako remedium na brak linków do tego fora, wybrałem 700 adresów podstron. Na liście kontrolnej umieściłem 10% adresów w SI i 10% nie zaindeksowanych podstron. Adresy te zostały wyświetlane losowo (random) na 5 dość mocnych domenach.

Wynik – niestety negatyw, strony z listy kontrolnej nie zmieniły „miejsca zamieszkania” albo były w SI albo nie było ich wcale.

Drugim etapem było umieszczenie na tych 5 domenach linków stałych (z całego serwisu) do miejsc gdzie były linki do podstron w SI.

Wynik tego testu był częściowo pozytywny, część podstron została „wybudzona”..

4. Autorski tekst umieszczony na subdomenie (nie zaindeksowana) Blogspotu – trzy wpisy. Adres tej subdomeny został umieszczony w 30 losowo wybranych katalogach. Strona została zaindeksowana po około 2 tygodniach od razy w całości wpadła w SI.

Byłem tym zdziwiony bo treści dość dużo do tego unikalna. Przyznam się, że mam wrażenie jakoby najdłużej trwało wyciągnięcie, tej domeny, do indeksu głównego.

Testy przebiegały poprzez linki stałe na 20 domenach – 1 miesiąc – nic.

Linki rotacyjne – 1 miesiąc – nic.

Na koniec usunąłem linki stałe i rotacyjne i dałem linki z dwóch moich dobrych domen + 20 wpisów w katalogach na podstronach ziandeksowanych bez SI.

Po dwóch miesiącach strona testowa wyszła z SI, nie jestem jednak w stanie stwierdzić, co ją wypchnęło.

5. Skrypt autorski – duże ilości treści na podstronach, częściowo treść powielona z innych serwisów. Codziennie pojawia się pomiędzy 200 a 2 tys, nowych podstron w zależności od domeny. Stron na tym skrypcie mam kilkanaście, nie mam problemu z zaindeksowaniem 50-100k podstron, jednak liczba podstron w SI zawsze oscylowała na poziomie 50%.

Część stron została przebudowana, zmieniona została nawigacja, dodane nowe elementy, meta Tagi indywidualne, usunięte powielające się treści.

Zostało też tutaj zastosowane linkowanie podstron do podstron.

Cokolwiek jednak nie robiłem % podstron w wynikach uzupełniających były wciąż takie same. Olśnienie :) przyszło jakieś dwa miesiące temu przy okazji hurtowej optymalizacji stron na jednym z moich serwerów.

Przyczyna tego stanu rzeczy okazał się trywialna. Skrypt posiadał błąd w nawigacji, okazało się, że winę za SI ponoszą listy podstron, ich liczba była ograniczona do 50 stron samej listy, po prostu stare postrony (najstarsze urle) znikały z list i prowadziły do nich tylko linki z innych podstron (dopiero od kilku tygodni), jednak mechanizm ten był niedoskonały i moc była za mała.

Usuniecie „blokady” na listach spowodowało zwiększenie indeksacji około 100% a zmniejszenie SI o 20%.

6. Skrypt autorski, domena o bardzo dużej „mocy” i wysokim TrustRank.

Do domeny prowadziło około 70k linków z kilku tysięcy domen. Stała liczba zaindeksowanych podstron na poziomie 200 tys. + 400k w SI.

W ciągu dwóch tygodni, na stronę, dołożyłem około 1,5 tys. linków stałych z 1,3 tys. domen (80% na stronę główną) + kilkadziesiąt tysięcy punktów w Coop (linki rotacyjne). Dodatkowo wybrałem około 120 podstron, jakie były liniowane w systemie linków rotacyjnych 7 dniowych, na moich domenach.

Na efekty nie trzeba było długo czekać, po około miesiącu ilość podstron zaindeksowanych wzrosła do ponad 0,5mln, ruch skoczył o 600%, ilość podstron w SI nie zmieniła się.

Przez około miesiąc ruch się utrzymywał, założyłem, więc, że podstrony nie wpadają do indeksu pomocniczego. Jednak po tym miesiącu ruch zaczął topnieć by ustabilizować się na poziomie około 50% większym niż przed testem.

Na dzień dzisiejszy site: stoi na poziomie 600 tys. a teoretycznie wyniki uzupełniające to 540 tys. podstron.

7. Strona na skrypcie WordPress – treść powiela się na maksymalnie 20 innych stronach.

W tamtym roku strona ta została dodana do około 300 katalogów + 1 „normalna domena”.

Google bardzo dziwnie potraktował ten serwis. Na początku roku cały wpadł do SI, po ostatnim eksporcie PR sukcesywnie była ona wyindeksowana, najpierw strona główna, po kolei podstrony.

Gdy zacząłem test na tej domenie w indeksie głównym było 0 podstron w wynikach uzupełniających pojawiały się 3 podstrony. Do strony zostały dodane linki z 10 stron głównych różnych domen.

Po około miesiącu adres główny strony pojawił się w wynikach głównych i do tej pory zwiększa się ilość zaindeksowanych podstron.

Pozycjonując inne strony, posiadając pewną liczbę domen w zapleczu po prostu do wyników uzupełniających trzeba się przyzwyczaić.

Nie ominie się ich dlatego, że mechanizm ten nie służy użytkownikom wyszukiwarki Google tylko ma na celu odciążyć jakże już „zmęczone” Data Center.

Według moich obserwacji, gdy bot trafia na stronę wyliczane jest „X” zmiennych, gdy te zmienne są poniżej wartości ale rPR prowadzący do podstrony jest na tyle duży by była uwzględniona w indeksie, podstrona taka trafia do wyników uzupełniających.

Co zrobić by zminimalizować SI na własnych domenach.

Podstawowa zasada to dużo linków do domeny oraz odpowiednia i sprawna nawigacja wewnątrz serwisu, także pomiędzy podstronami.

Jeśli używasz skryptu ogólnodostępnego, np. blogowego, to postaraj się jak najbardziej odróżnić ten skrypt od tysięcy domen, na jakim jest używany.

Zmiana urli na niestandardowe, dołożenie unikalnych elementów z treścią.

Zdjęcie nie jest treścią!

Jeśli Twoje podstrony nie różnią się wiele, mają te same meta tagi, to spraw by były one unikalne dla każdej podstrony.

Pamiętaj o tym, że opis powinien zawierać minimum 60 znaków, najlepiej by były to unikalne zdania.

Wprowadź jakieś elementy, które zwierają tekst, może to być nawet wyświetlanie jakże popularnych cytatów, czym więcej w % będą się od siebie różnić tym lepiej.

Na wszystkich stronach/serwisach warto zadbać by podstrony nie zawierały informacji o błedach php, mysql itp. itd. oraz by w obrębie witryny było mało nieistniejących podstron 404 oraz 302.

Podstron z przekierowaniem 302 można wygenerować tysiące przy „ErrorDocument 404 /”.

Wrócę jednak znowu do linków.

Jakkolwiek nie przerobisz serwisu, nie zoptymalizujesz go, jeśli do domeny nie będzie prowadziła odpowiednia ilość linków z odpowiednią mocą to nawet unikalne podstrony prędzej czy później trafią do indeksu pomocniczego.

Nie wolno zapomnieć o linkowaniu podstron, ja stosuję zasadę, że minimum 20% linków do domeny są to linki do podstron.

Preferuje też linki stałe a rotacyjne tylko w naprawdę dużych ilościach.

Wszystko zależy od zasobności „zaplecza”, jakim dysponuje pozycjoner.

Obserwując wiele domen przez okres ponad 6 miesięcy zauważyłem też, że podstrony, na które jest więcej wejść w miesiącu niż 50UU nie wpadają w SI, przynajmniej u mnie.

Podaję to bardziej jako ciekawostkę niż niezaprzeczalny fakt.

Czy warto dbać o jak najmniejsze SI na swoim zapleczu?

Według mojej opinii tak, pozycjonowanie stron to mechanizm, który jest tak sprawny jak sprawne jest Twoje zaplecze.

Jeśli zaplecze w większości „przebywać” będzie w indeksie pomocniczym to niestety jego moc będzie znikoma do walki o pozycje w indeksie głównym.

P.S.

Z braku czasu tekst wynikowy jest mocno okrojony w porównaniu do moich notatek oraz brak w nim screen`ów obrazujących to co robiłem, myślę jednak, że ktoś znający pojęcie „wynik uzupełniający” bez problemu zrozumie to co chciałem tutaj przekazać.