Sprzed 23 godzin

Ot, taka ciekawostka…

Ot, taka ciekawostka…

Do napisania tego wpisu zmusił mnie niejako jeden z właścicieli systemów wymiany linków, twierdząc, że się „czepiam” :/

Postanowiłem dokładnie sprawdzić na ilu stronach, na których niby wyświetlają się moje „pozycjonujące” linki, w systemach wymiany linków stałych, to „puste” miejsca zabierające tylko punkty.Jak ważne jest to aby system skutecznie wyłapywał wszelkie oszustwa nie trzeba nikomu chyba tłumaczyć.

Sprawdziłem trzy systemy, w których posiadam aktywne konta, są to dwa polskie systemy LiveLink, LinkMe oraz najpopularniejszy na świecie system linków stałych – Link Vault.

W tym miejscu zaznaczę, że nie jestem zwolennikiem pozycjonowania stron tylko poprzez systemy. Moim zdaniem powinny być one pomocne tylko jako dodatek do tego, co robimy. Jak wiemy różnie to bywa, są tacy „pozycjonerzy”, dla których jest to jedyny sposób pozyskania linków i do nich głównie kierowany jest ten tekst, choć nie tylko.

Sprawdzanie odbywało się w dwóch etapach.

Pierwszy, sprawdzenie skryptem, specjalnie napisanym do tego celu. Skrypt wyszukuje w kodzie strony danego adresu strony, czyli linku, który powinien tam być, nie anchora bo to mogłoby zaciemnić wynik.

Skrypt zgłaszał się jako „Mozilla/4.0 (compatible; MSIE 5.0; Windows NT) z timeout ustawiony na 30 sekund.

Drugi etap to sprawdzenie ręczne, stron oznaczonych jako „brak linku”.

Dla stron, które się nie otwierały lub dawały 404, 500 lub błędy skryptów tam umieszczonych, sprawdzałem kopie Google, jeśli nie znalazłem kopii podstrony zakładałem, że link tam jest.

Niestety, po zliczeniu wszystkiego zauważyłem, że popełniłem mały błąd bo nie zapisałem sobie ilości stron, na których nie byłem w stanie ustalić „jest/nie ma” jednak takich przypadków nie było wiele, bodajże po 3-5 dla polskich systemów i 1 dla LV.

LiveLink

Sprawdziłem 264 strony, nie znalazłem linku na 55 szt. co daje 20,83% – nie mało nieprawdaż?

W przypadku tego systemu najczęściej po prostu nie było linków, widziałem parę stron z przekierowaniem 301 z podstrony, którą miałem na liście, na stronę główną. Kilka podstron nie istniało, mimo, że strona działała a jej struktura nie została zmieniona, najczęściej były to katalogi, gdzie wpis został usunięty, więc podstrona znikła.

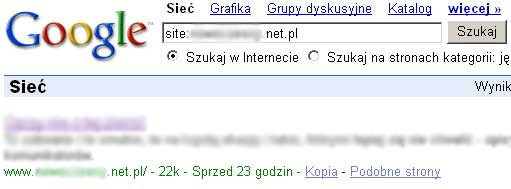

Jednak, co ciekawe, znalazłem jeden kwiatek, czyli zaparkowaną domenę, z kopią wskazującą, że ten stan trwa już od tygodnia.

Myślę, że spider tego systemu powianiem to dawno już wyłapać.

Nie ukrywam, że w przypadku tego systemu pierwszą akcję sprawdzania przeprowadziłem prawie dwa miesiące temu, niestety mimo zgłoszenia przez „detektywa” strony nie zostały usunięte i dość duża ilość ponownie została wyłapana jako nie emitujące linków.

LinkMe

Sprawdziłem 210 strony, nie znalazłem linku na 28 szt. co daje 13,33%. Jeśli chodzi o % już jest lepsza sytuacja, spider systemu jest trochę bardziej skuteczny niż w LiveLink.

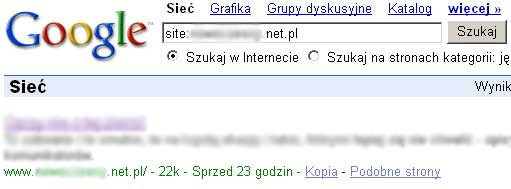

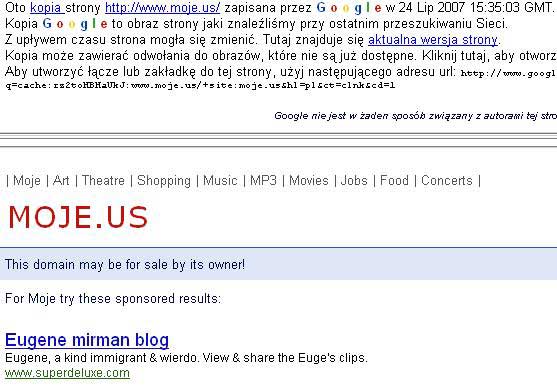

Tutaj tak samo najczęściej po prostu nie było „mojego” linka, były nieistniejące podstrony oraz 301. Nie obyło się też bez „kwiatka”, jakim okazał się zbanowana domena w Google.

Pozycjonowanie stron dzięki zbanowanym domenom … hmm.

Niestety nie jestem w stanie określić, kiedy to było, więc istnieje szansa, że np dzień prędzej i bot tego systemu nie zdążył jej wyrzucić.

Link Vault

Sprawdziłem 226 strony, nie znalazłem linku na 12 szt. co daje 5,31%.

Jak widać w tym systemie najmniej traci się punktów na „puste linki”, więc pozycjonowanie tym systemem będzie bardziej skuteczne.

Faktem jest, że myślałem, że w tym systemie będzie mniej takich stron.

Nie znalazłem tutaj żadnego ciekawego przypadku a linków po prostu nie było.

Podczas sprawdzania tych systemów, założyłem, że górna granica tolerancji, brakujących linków, to 3-5%. Założyłem też, że nie jestem odosobnionym przypadkiem, dlatego uważam, że patrząc na system jako całość, procenty, niewiele się zmienią.

Niestety żaden z systemów się w tej granicy nie zmieścił.

LV był blisko, jak widać, system jest od strony kontroli najlepiej dopracowany.

Procenty polskich systemów są niestety za wysokie, Panowie Właściciele -Administratorzy!

Już 13,33% jest przerażające, ale 20,83% to już koszmar.

Na każde 1000 linków 133szt. albo 208szt. po prostu nie istnieje. Najgorsze jest to, że te ilości, często, pozwoliłyby na pozycjonowanie kolejnej frazy albo wzmocnienie zaplecza.

Jeden, jednak plus dla systemu LiveLink, jest to eksport linków do pdf. Naprawdę ułatwia to automatyczne sprawdzenie, za to w LinkMe, mam wrażenie, że podzielenie listy po 10szt. na podstronę jest celowym działaniem by utrudnić sprawdzanie. Kopiowanie tych linków zajęło mi kilkanaście minut, jakbym chciał sprawdzić 2000 to pewnie zniechęciłbym się szybko. Może zrobiłbym to raz ale nie cyklicznie.

Niestety LV nie jest lepszy od LinkMe pod tym względem, fakt listę utworzyłem szybciej, ale tylko dzięki rozszerzeniu FireFoxa „Web Deweloper” + czyszczenie z niepotrzebnych rzeczy.

Na koniec chciałbym dodać, że nie oceniam skuteczności tych systemów, pod kątem pozycjonowania. Faktem jest jednak to, że jakby ilości stron, które nie emitują linki, były mniejsze to systemy te byłby jeszcze bardziej skuteczne.

Zachęcam wszystkich do samodzielnego sprawdzenia swoich list, oraz zgłaszania tego do systemów, na pewno przyczyni się to do wzrostu wartości Waszych punktów.

P.S.

W LinkMe dziś „zadenuncjuję” te strony jednak Pana z LiveLink, jeśli jest zainteresowany proszę o kontakt, bo kolejny raz na zgłaszanie tracić czasu nie będę.

Wczoraj na oficjalnym blogu Google dla webmasterów pojawiła się wypowiedź, wyjaśniająca pewne mechanizmy, jakie trzeba brać pod uwagę przy pozycjonowaniu stron.

„Does location of server matter? I use a .com domain but my content is for customers in the UK.

In our understanding of web content, Google considers both the IP address and the top-level domain (e.g. .com, .co.uk). Because we attempt to serve geographically relevant content, we factor domains that have a regional significance. For example, „.co.uk ” domains are likely very relevant for user queries originating from the UK. In the absence of a significant top-level domain, we often use the web server’s IP address as an added hint in our understanding of content.”

Jak widać potwierdziło się to o czym pisaliśmy już od dawna. Fizyczna lokalizacja serwera ma znaczenie w określaniu pozycji. Zastanawia mnie tylko użycie w przykładzie co.uk, a co za tym idzie wyszukiwarki dla Wielkiej Brytani. Właśnie na tym przykładzie najlepiej to widać, czyżby jednak tylko dla niektórych państw miało to aż tak „kolosalną” wartość?

Ciekawy jest też ten fragment:

„I have many different sites. Can I cross-link between them?

Before you begin cross-linking sites, consider the user’s perspective and whether the crosslinks provide value. If the sites are related in business — e.g., an auto manual site linking to an auto parts retail site, then it could make sense — the links are organic and useful. Cross-linking between dozens or hundreds of sites, however, probably doesn’t provide value, and I would not recommend it.”

Cross-linking jest to linkowanie pomiędzy tymi samymi stronami na zasadzie

A–>B, B–>A, czyli na jednej stronie jest link do drugiej, na której jest link „powrotny”.

Jak widzimy wypowiedź jest napisana w kontekście przydatności takiego mechanizmu dla użytkownika a nie mechanizmów jakie zachodzą w wyszukiwarce.

Zastanawia mnie fakt, że zostało to zanegowane tylko w przypadku takiego linkowania pomiędzy sobą stron niepowiązanych ze sobą tematycznie. Jeśli ktoś posiada kilka stron kilka stron i tej samej tematyce to jest to już sensowne.

Z obserwacji wielu ludzi z przed kilku lat wynikało, że przy pozycjonowaniu stron nie jest to dobry mechanizm, czyżby nastąpiły jakieś zmiany, które nie zostały jeszcze zauważone, przez pozycjonerów?

Tym sposobem na mojej liście „do testowania” pojawił się kolejny punkt.

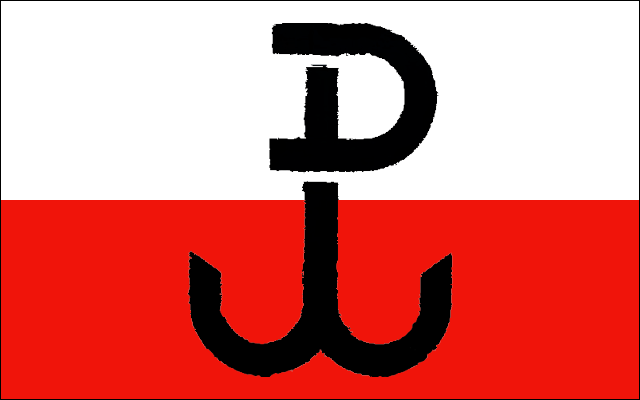

63 lata temu o 17.00 wybiła godzina „W”

Pamiętajmy o takich dniach!

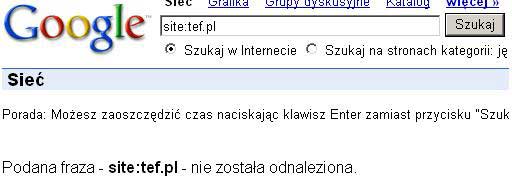

Od dnia dzisiejszego Google nie oznacza już stron w wynikach uzupełniających.

Tak piszą na Google Webmaster Central Blog

„……Given all the progress that we’ve been able to make so far, and thinking ahead to future improvements, we’ve decided to stop labeling these URLs as „Supplemental Results.”

Zobaczymy, czy dzisiejsze zmiany, bo pewnie nie chodzi tylko o słowa „wynik uzupełniający” wpłyną na odwiedzalność naszych stron czy ich pozycjonowanie i jakie to zmiany będą, na plus czy minus.

Tak się zastanawiam ile dzisiaj punktów przybyło pozycjonerom w systemach wymiany linków, które nie zliczały stron w SI.

Jak zawsze, przy większych zmianach w Google, na wszelkiego typu komentarze i przemyślenia radzę poczekać kilka tygodni.