Google – przyszło nowe

Ostatnie dni obfitowały w zmiany w Google oraz jedną katastrofę.

Niektóre zmiany już się dokonały, na inne poczekamy do czasu wejścia nowego silnika w życie.

Patrząc po wypowiedziach na forach lub innych blogach tematem numer jeden jest:

1. Personalizacja wyników dla osób nie zalogowach w Google

W tamtym tygodniu nagle podniosła się wrzawa, że koniec pozycjonowania już blisko bo Google zaczęło personalizować wyniki wyszukiwania dla wszystkich…

![]()

…. i zapanowała jakaś swoista panika wśród pozycjonerów. Że to będzie SEO killer, bo teraz wyniki same się będą ustawiały pod usera więc SERPy będą różne dla każdego. Że tylko duże witryny będą miały lepiej. Że już widać spadki w ruchu bo długi ogon leci…

Trochę prawdy w tym co piszą jest, lecz mam wrażenie jakby piszący na dzień dzisiejszy trochę przesadzali.

Sama idea personalizacji wyników dla każdego nie podoba mi się. Uważam, że powinien mieć wybór czy chce taką funkcje.

Mimo, że zostaliśmy uszczęśliwieni tym na siłę, może jednak zmienimy o tym zdanie tak jak wielu zmieniło zdanie o podpowiedziach słów przy wyszukiwaniu.

Ale do rzeczy:

W personalizacji na pewno mamy mechanizm, który sprawia, że odwiedzone strony będą wyżej w wynikach niż te które pominęliśmy. Przy wyszukiwaniach na inne słowa kluczowe, odwiedzone witryny będą miały bonus w pozycjach.

Niby ważny jest czas jaki spędzimy na danej witrynie. Te, na których jesteśmy dłużej pną się wyżej w naszym prywatnym rankingu.

Wielu w tym widzi zagrożenie bo przecież będą dość wielkie roszady w SERPach. Zapominają jednak, że będą to zmiany lokalne dla jednego usera (przynajmniej na dzień dzisiejszy), więc dla wielu innych użytkowników wyszukiwarki, pozycje będą takie jak ustawiają im pozycjonerzy (albo wyszukiwarka hehe).

Nie zapominajmy też o tym, że jeśli wyłączanie personalizacji nie jest w 100% poprawne, to możemy zakładać, że i personalizacja będzie co jakiś czas ustawiana od nowa.

Innym mechanizmem, który według mnie będzie w personalizacji lub już jest to wyświetlanie behawioralnych wyników w SERPach. Jeśli tego nie będzie, moim zdaniem, zostanie zatracona cała idea personalizacji.

Mechanizm ten miałby dobierać wyniki do aktualnych zainteresowań szukającego.

Dla przykładu wpisując „drzwi Poznań” po chwili wyszukiwania dostaje tylko wyniki z drzwiami wewnętrznymi bo tylko takie linki klikam i przeglądam. Wpisując „foteliki dziecięce” wyniki ustawiają mi się głównie pod kątem samochodowych fotelików a nie np fotelików do domu dla lalek.

Uważam, że ten mechanizm wpłynie bardziej na ruch w witrynach niż proste podbijanie pozycji odwiedzonych witryn.

Jednak wprowadzenie przez Google jakiejkolwiek personalizacji daje sygnały na przyszłość, że wyniki naprawdę mogą być ustawianie w dużej mierze przez użytkowników a nie algorytm i matematykę.

Po prostu próbka danych jaką Google otrzymuje to piękna podstawa do analizy, które witryny są OK a które już takie nie są.

Wiele nie trzeba myśleć by dojść do wniosku, że prędzej czy później Google tą wiedzę wykorzysta a wtedy pozycjonowanie rzeczywiście będzie zagrożone.

Na zagranicznych formach już teraz można przeczytać opinię, że pozycje są uśredniane poprzez odwiedziny użytkowników. Tzn, że już teraz wejście pewnej ilości ludzi ma wpływ na pozycje dla tych, którzy szukają.

Osobiście uważam, że po kilku dosłownie dniach lepiej takich opinii nie przedstawiać, jak i z innymi sprawami, w pozycjonowaniu lepiej poczekać i obserwować.

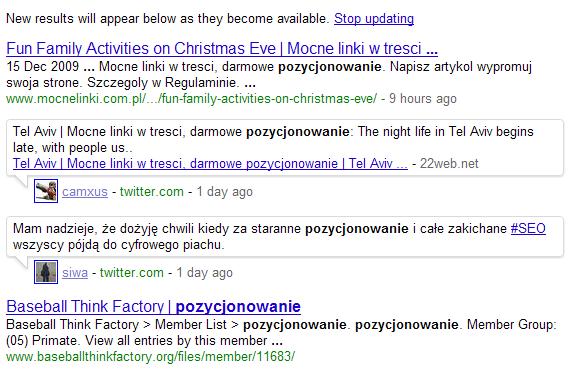

2. W SERPach pojawiały się wypowiedzi z mikroblogów bez opóźnienia w czasie.

To jest nowa funkcja, która mało zainteresowała pozycjonerów bo i z pozycjonowaniem niewiele ma wspólnego.

W Google światowym podczas wyszukiwania można się natknąć na wpisy z Twittera. Są one wyświetlane w czasie rzeczywistym bez opóźnień związanych z indeksacją.

Z tego co na razie widzę, mechanizm ten jest już testowany przez spamerów.

wyszukanie - "pozycjonowanie" z opcją "najnowsze"

„Wyniki live” (nie wiem czemu tak to niektórzy nazywają) jak widać mogę być niesamowitym narzędziem SEM.

Umiejętnie napisany wpis pojawia się na pierwszej stronie wyników danej frazy = potężna liczba wejść za niewielkie pieniądze lub za darmo.

Na razie z tego co czytałem, mechanizm wymaga dopracowania bo można przemycić w wyświetlanych wpisach treści, które nie powinny się tam pojawiać.

3. Biedny parametr „site”

Ten punkt powinien rozbić na dwa podpunkty.

a)

Pojawiała się informacja, że w nowym silniku Google, nie będzie wyświetlana ilość wyników używając tego operatora.

Do tej pory cyferka ta służyła nam pozycjonerom, do określania ilości zaindeksowanych podstron w wyszukiwarce.

![]()

Była to wielce przydatna informacja bo można było z niej wyciągnąć wiele wniosków. Pośrednio można było poznać moc linków jakie prowadziły do sprawdzanej witryny, ogólne tendencje w Google (indeksowanie), filtry, szybkość rozrostu witryny, problemy z nawigacją itp itd.

Można napisać, że od zawsze to było a teraz prawdopodobnie zniknie – no trudno.

Jest jednak jeden problem, dotyczy on w mniejszym lub większym stopniu większości pozycjonerów. Dla większości systemów wywiany linków parametr ten jest głównym modyfikatorem ilości punktów.

Wrzawa się podniosła, co teraz?

Do tej pory było łatwo. Dużo zaindeksowanych podstron = dużo podstron do emisji linków. Wystarczyło dodać do tego jakieś plusy lub minusy za różne rzeczy związane z witryną i po kłopocie.

Nie jest to mechanizm sprawiedliwy ale dzięki tej prostej metodzie wyliczano ile ktoś daje do systemu a ile może zabrać.

Niedługo jednak to zniknie…..

Co dużo pisać jeśli tak się stanie systemy będą musiały wymyślić nowy sposób oceny witryn a może to spowodować zmiany na podium liderów. Wszystko zależy od tego co zostanie wdrożone po zniknięciu tych cyferek.

b)

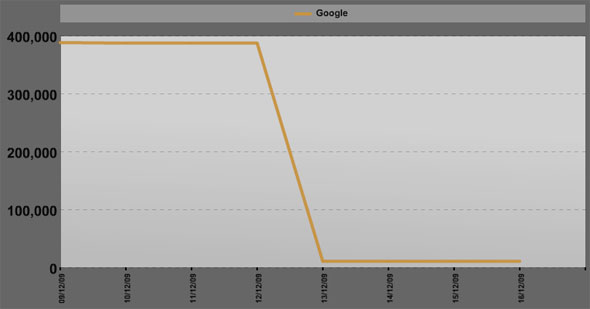

Kilka miesięcy temu w Google nagle zwiększyła się ilość wskazywanych zaindeksowanych podstron. Od razu odbiło się to w ilościach punktów będących w obiegu w SWLach.

W miniony weekend wśród użytkowników e-Weblinka zapanowało poruszenie bo nagle site zaczął wyparowywać.

Jak pokazuje systemowy wykres w ciągu dwóch dni ilość podstron systemie spadła o około 190 mln (około 60% całości).

Na razie „tragedia” ta dotknęła tylko ten system. Prawdopodobnie dlatego, że używa on ogólnoświatowych DC a nie polskich.

Moje narzędzia, które codziennie sprawdzają mi ilość zaindeksowanych podstron także pokazują niezłe spadki (także korzystam z DC dla google.com).

Co ciekawe spadki te nie przełożyły się w widoczny sposób na zmniejszenie ruchu, więc można założyć, że Google odfiltrowuje to co jest niepotrzebne. Ruch oczywiście spada ale uważam, że jest to wynik handlowego weekendu przed Świętami.

Na dzień dzisiejszy sprawa trochę się uspokaja, spadki się ustabilizowały na pewnym poziomie.

Tak się zastanawiam czy nie jest to celowe działanie Google polegające na wyczyszczeniu podstron przez przełączeniem na nowy silnik?

Do Świąt został tydzień, więc na pewno wykonują już jakieś działania przygotowujące Google do takiej zmiany.

Ciekawy koniec roku mamy, ciekawe co nas jeszcze czeka…..

komentarzy

komentarzy

Bardzo ciekawy artykuł. Dzięki Kolego!

Hmm, zawsze mam kłopot z takimi komentarzami od nieznanych mi osób.

Panto, nastepnym razem więcej konkretów to zostawie urla pod nickiem.

Pozdrawiam i dzięki.

Zmiana silnika była i jest kontrowersyjna. Nie wiem czemu google na siłę chce pozbyć się Pozycjonerów, ale wiem że nie wróży to dobrze. Zmiany w Google na moich stronach nie wróżą na przyszły rok dobrej nowiny. Jeżeli serpy będą targetowane to moje roczne męki dla hasła „darmowe forum” mogą pójść na darmo :(

Nieslychanie ciekawy artykul. Czy moglbym prosic o rade gdzie najlepiej zaczac sie uczyc nt. pozycjonowania stron. Bo mam wrazenie, ze wiedza do zdobycia jest obszerna, stale zmienna w czasie i podejrzewam, ze ilosc blednych informacji na te tematy jest rowniez duza. Co czytac? Gdzie sie uczyc?

Pozdrawiam,

Piotr Mrozinski

alled.pl

Muszę niestety napisać, że w Polsce chyba najlepsze źródło to forum.optymalizacja.com.

Polecam też czytać blogi, tylko proszę pamiętać, że wszystkie ciekawsze informacje pisane są między wierszami.

Podstawowa zasada to myśleć przy czytaniu bo każdy z nas opisuje swoje doświadczenia i wnioski jakie z nich wyciąga.

Mogą być one jednak błędne…

Jak ma Pan jakieś konkretne pytania to mogę na nie odpowiedzieć w formie wpisu na blogu.

Moim zdaniem, Google dobrze odfiltrowując śmieci, chociaż do końca się ich nie pozbędzie. W życiu tak to jest, że usuniesz jednego szkodnika na jego miejsce pojawi się dwóch. Ale z drugiej strony mogą zacząć nakładać filtr na całe IP lub domeny, a to może zniechęcić pseudo pozycjonerów, bo szybko stracą zaplecze. SWL już nie dają kopa, trzeba po prostu inwestować w „good content”.

Na domeny już dają od dawna przecież a na IP niby też ale sam się nie spotkałem z tym jeszcze. Filtr na witryny w danym IP mógłby objąć i takie, które nie zawiniły niczym , więc chyba byłoby to obarczone za dużą dozą błędu.