W marcu poprzedniego roku jedną z moich witryn dotknął przedziwny filtr blokujący ilość podstron widocznych w indeksie Google.

Zafiltrowana witryna to jeden z moich katalogów, który założyłem w 2006 roku na skrypcie Easy-Directory. Jak już pisałem dbam o moje katalogi, linkuje je odpowiednio i moderuje, nie umieszczam na nich żadnych SWLi, więc zdziwiłem się, że zostałem „obdarzony” takim filtrem.

Gdy ilość zaindeksowanych podstron gwałtowanie zmniejszyła się do 12 sztuk, pomyślałem, że jest to zwykłe wyindeksowanie i po jakimś czasie wróci wszystko do normy. Gdy jednak miesiąc później zauważyłem, że nic się nie zmieniło postanowiłem coś z tym zrobić.

W indeksie widziałem tylko stronę główną parę kategorii i podkategorii oraz jedną podstronę ze szczegółami wpisu. Ta podstrona była nieźle podlinkowana przez pozycjonera, który dodał ten wpis.

W pozycjonowaniu najważniejsze są linki, tak samo w indeksacji. Dlatego też pierwsze co zrobiłem to podlinkowanie strony głównej oraz paru podkategorii i wpisów.

Niestety mimo mojej pracy nic się nie zmieniło …

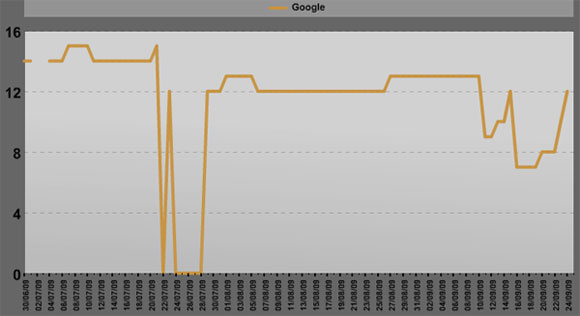

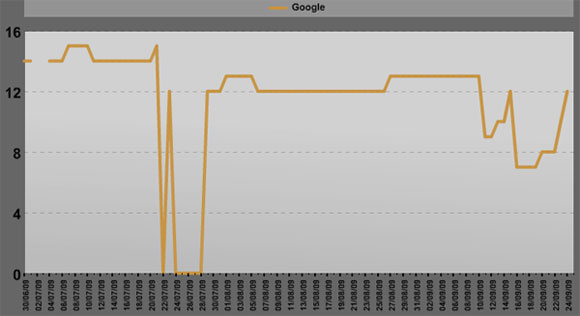

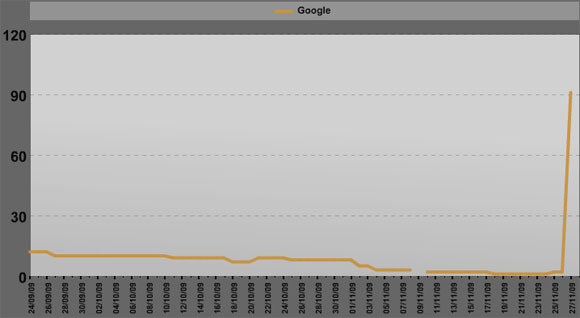

Wykres od 30.06 do 24.09.2009

Spadki na 0 są wynikiem intensywnej pracy z wyszukiwarką i blokadą (403) moich IP w Google.

Dodanie linków przyniosło wzrost liczby zindeksowanych podstron w Yahoo i w MSN, jednak nie o to mi chodziło.

Dlatego też 24.09.2009r. poświęciłem tej witrynie trochę czasu i

– przebudowałem linkowanie wewnętrzne, dodałem parę nofollow. Na podstronach podkategorii usunąłem linki bezpośrednie do witryn zostawiając jedynie link do szczegółów wpisu,

– zmieniłem URLe podstron wg najprostrzej zasady –> „kat-” to teraz „kategoria-, podkategoria to teraz „pod-” itd.. Chodziło mi tylko o to by boty dostały nowe nazwy podstron, zauważyłem już dawno, że bardzo to lubią,

– zmieniłem stałą część meta Description na prawie każdej postronie,

– zmieniłem układ podstrony ze szczególami poprzez przestawienie elementów miejscami,

– w pionowej kolumnie dodałem newsa z RSSa tak by pojawiał się na nowych podstronach dodatkowy tekst,

– usunąłem z witryny wszystkie moje linki, kóre mogłem usunąć (z topu, stopki itp),

– dodałem parę drobnych elementów jak np tekst w stopce informujący jaki dziś dzień i która godzina,

– oczywiście w htaccess dodałem przekierowanie ze starych adresów podstron na nowe. Zastanawiałem się jakiś czas czy to zrobić (czy nie przeniosę filtra) ale doszedłem do wniosku, że szkoda mi jednak mocy jaką pozycjonerzy włożyli w swoje wpisy.

Jak widzicie i tym razem zmiany jakie dokonałem ograniczały się tylko do takich, które może dokonać prawie każda osoba, która ma parę stron ale nie zna się na programowaniu. Doszedłem do wniosku, że jeśli to nie pomoże dopiero zacznę się zastanawiać co zmienić w samym skrypcie (skrypt?) by wyjść z tego filtra.

Po dokonaniu zmian uzbrojony w cierpliwość oczekiwałem efektów… długo przyszło mi jednak czekać… :)

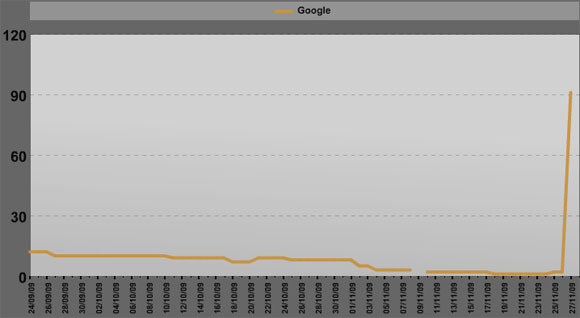

Już 27.09 ilość podstron w Google zaczęła się powoli zmniejszać.

Od 18.11 do 24.11 widoczna była tylko strona główna.

Zacząłem się zastanawiać co się dzieje i co będę musiał zmienić jeszcze by wszystko wróciło do normy.

Jednak 25.11 pojawiała się druga podstrona a 27.11 widać ich było już 91 szt.

Wykres od 24.09 do 27.11.2008

Jak widać filtr został pożegnany jednak postanowiłem poczekać jeszcze parę tygodni na „świętowanie” by upewnić się, że wszystko jest OK.

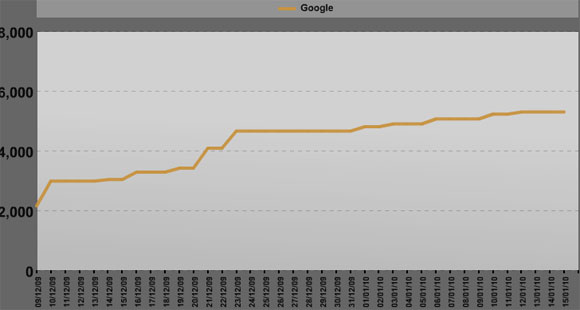

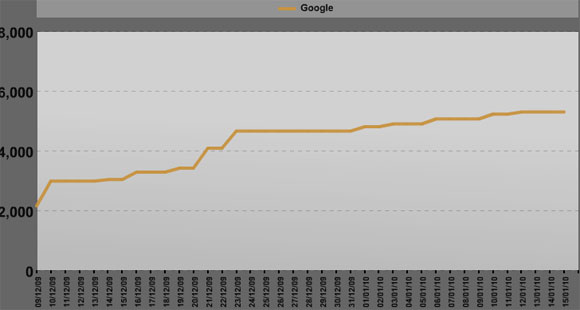

Wykres od 2.12.2009 do 15.01.2010

9 grudnia było już widoczne 2150 podstron, dziś jest 5290.

Jak widać żadne przedświąteczne wariacje Google nie dotknęły tej witryny. Wzrost już jest wolniejszy ale stały. Zmiany choć tak naprawdę niewielkie spowodowały dużo korzyści zwłaszcza biorąc pod uwagę fakt, że jest to katalog stron i wpisy zostały na nowo zaindeksowane.

Dodam jeszcze, że nie jest to moje pierwsze „spotkanie” z takim filtrem. Miałem już raz przypadek zamrożenia ilości podstron w okolicy 1 tysiąca, poradziłem sobie z tym w podobny sposób.

Dwa lata temu kupiłem używaną wcześniej domenę, po wypełnieniu ją treścią w Google było widoczne jedynie 13 podstron a powinno być dużo więcej. Z tamtym przypadkiem sobie nie poradziłem ale też niewiele sił w to włożyłem. Po prostu nie przedłużyłem tej domeny na kolejny rok.

Ostatnio na jednej z moich domen wrzuciłem jakiś skrypt z bazą dowcipów, powielanych już wiele razy na wielu nie tylko moich zapleczach. Tu sprawa jest o tyle ciekawa, że od razy w indeksie pojawiły się 4 podstrony i tak jest do tej pory. Żeby było śmieszniej nie ma w śród nich strony głównej. Podejrzewam, że tu nałożyło się więcej filtrów niż tylko na indeksowanych podstron (powielenie treści i skryptu). Jak będę miał czas to spróbuje się i tego pozbyć….

Podsumowując jeśli pozycjonujesz jakąś witrynę a Google gwałtownie obniżył ilość podstron w indeksie. Jeśli trwa to długi czas to może warto pomyśleć nad lekkim przebudowaniem witryny by zachęcić bota do odwiedzin…

Przebudowa witryny często pomaga też przy usunięciu filtrów na frazy, można więc upiec dwie pieczenie na jednym ogniu.

komentarzy

komentarzy